美国商务部长示警黄仁勋“芯片不准卖中国”,英伟达“中国特供”生意将如何延续

英伟达CEO黄仁勋 (Jensen Huang) (图片来源:AFP)

中国市场,对于万亿芯片巨头英伟达(NVIDIA)来说至关重要。

2022年,英伟达公司总收入中,有超过57亿美元(占比25%)来自中国客户,尤其包括阿里、腾讯、字节跳动等互联网科技大厂,他们一直对英伟达的算力产品A100/H100处于“疯狂买买买”状态。

然而,随着2022年10月、2023年10月,美国商务部工业和安全局(BIS)两次更新对中国的先进半导体和计算设备的出口管制,英伟达中国特供版GPU产品A800、H800芯片均已经于11月17日起在中国禁售。与此同时,AMD发布的性能最强的MI300X、MI300A、MI250X、MI250等多款 AI 芯片也不再能出口到中国了。

虽然《隋唐演义》中称“穷不与富斗,富不与官斗”,但黄仁勋却认为,英伟达是一家要赚钱的“商业公司”,希望尽可能和所有人做生意。

因此,英伟达最终和美国政府进行了一场“猫鼠游戏”。

12月6日,在美国商务部长雷蒙多(Gina Raimondo)已公开示警下,英伟达CEO黄仁勋却在新加坡的一场会议中表示,英伟达将继续为中国市场提供合规芯片产品,预计“特供”芯片将包括HGX H20、L20 PCle、L2 PCle等。

黄仁勋强调,公司将继续“完全遵守”美国政府的贸易法规。他直言,芯片产业链依然处于全球化,美国芯片制造商距离供应链独立至少还有10年-20年时间。

前一天,雷蒙多则对于芯片出口管制的态度依然强硬。她直言,“绝不能让中国芯片技术赶超美国。我们不能让中国得到这些(最尖端)芯片,永远都不能”。雷蒙多还点名英伟达,“我们的意图是拒绝中国的技术。如果你(英伟达)绕着特定的规定重新设计一款芯片,让他们能够从事人工智能项目,我就会在第二天对它(芯片)进行管制。”

“从 AI 算力本身来说,美国英伟达禁止向中国销售H800算力下,我自己判断,(中国 AI 产业)大概有2-3年的落后差距,至少是顶尖大模型算力。如果明年英伟达还会发布新产品的话,可能这个差距还会增加。”一家大模型公司CEO杨迪文(化名)近日在深圳一场活动上表示。

杨迪文坦言,“如今,我们(中国公司)已经拿不到全球最好的 AI 算力芯片了。”

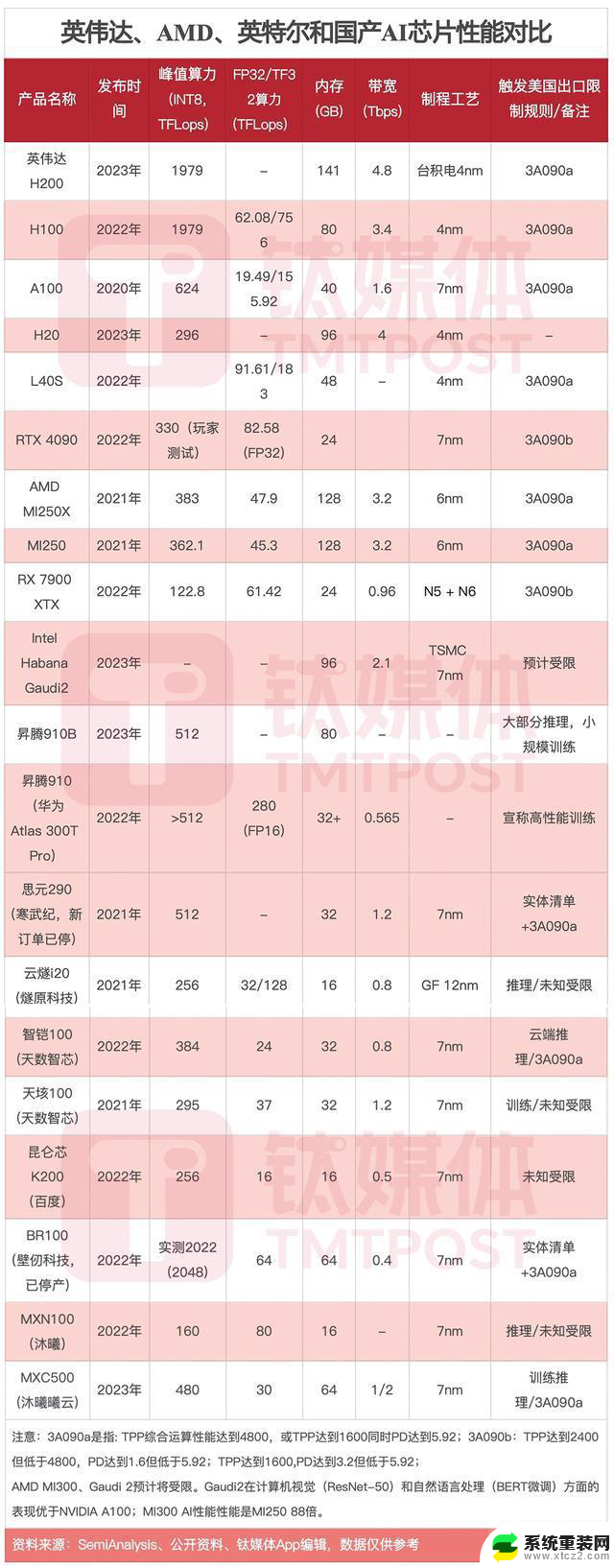

英伟达、AMD、英特尔和国产AI芯片性能对比(来源:钛媒体App编辑整理)

猫鼠游戏下的英伟达“缩水”芯片,为何还有人买?上面这张图提到的3A090,是今年11月17日起正式实施的美国商务部BIS最新出口管制中的ECCN编码物项。

具体来说,3A090特指特定高性能集成电路。在数据中心应用场景下,当一颗芯片输入输出双向传输速率超过每秒600GB,或算力超过4800TOPS时就属于3A090a,也就意味着该芯片将禁止向中国出口和销售,而3A090b则属于非数据中心芯片的超出其所限制的性能指标。

在2002年10月版的出口管制措施中,美国政府并未设立上述这种“算力”标准。新规当时确定的高算力芯片判断依据有两个方面:一是其算力峰值超过或达到4800 TOPS,二是传输速率超过或达到600GB/秒。那么,一旦芯片产品达到这一性能参数,就会被纳入出口管制的范围内。

“这两个技术参数之间是‘且’的关系,需要同时达到才会触发出口禁令,英伟达很好地利用了这个政策框架,推出了A800芯片。”一位行业人士表示。

所以,英伟达A100芯片的性能参数恰好符合上述要求,也因此受到当时出口管制的影响。随后,英伟达推出A100、H100在中国销售的“特供版”芯片A800、H800,尽管同架构、同样配备高带宽插槽(SXM)版本,但芯片数据传输速率下降、内存带宽降低。如果企业不买NVLink互连技术,H800性能和传输速率比H100要少60%以上。

那么,性能暴降、价格节节攀高的英伟达“中国特供”芯片,为何还有人买?

根据与多位行业人士交流,钛媒体App整理了以下三个主要因素:AI 对于高算力需求火爆,GPU的关键作用,以及国产 AI 芯片生态弱。

首先,即便性能暴降。但2023年,以ChatGPT为代表的 AI 大模型爆火,面临经济衰退的云厂商全部挤进大模型赛道,AI 训练芯片成为“爆品”,包括阿里、腾讯、百度大抢A100、H800芯片,英伟达也因此成为中国 AI 大模型领域关键“军火商”——营收超过台积电、英特尔,年内股价暴涨220%,市值涨到1万亿美元,成为全球第二大半导体公司、第七大科技巨头。

具体到案例中,生成式AI对算力的具体需求主要体现在搜索、办公和计算机等场景中。例如,如果谷歌采用GPT等大模型用于推荐搜索,每天需要处理35亿次搜索请求,按照GPT-4 API 0.14元/次的价格,每年需要支付1788亿元人民币的API费用。若采用自建算力集群的方案,需要提供每秒约10万次的峰值访问能力,一轮GPT-4对话涉及200多万亿次浮点运算,在计算资源利用率约60%的情况下,需要约10万块A100集群;如果微软office使用大模型办公,按每人每天10次的访问需求计算,中国的学生与白领人群达到2.8亿人,每年具有1.02万亿次访问需求,需要8万块A100的算力支持。如果12亿网民都要有一个定制化的AI个人助理(大模型原生应用),在每人10次的日访问条件下,需要34万块A100算力支持。

目前,OpenAI使用1万-3万颗英伟达GPU来训练GPT-3.5模型。集邦咨询数据显示,如果以英伟达A100显卡的处理能力计算,运行ChatGPT将可能需要使用到3万块英伟达GPU显卡。另外在开源模型方面,Llama模型则是在2048块80GB A100上训练,整个训练算力接近2000P算力。

百川智能创始人、CEO王小川表示,OpenAI团队现在正在尝试把1000万颗GPU连在一起训练一个大规模的模型。而英伟达一年大概生产100万颗GPU,训练GPT-4需要2.5万颗GPU芯片,GPT-3.5国内训练需要4000颗。

AI 技术严重依赖于高算力,但目前在大模型训练算力方面,只有英伟达才能做到,也能做到最好。

最新财报显示,截至今年10月29日的第三季度,英伟达实现营收181.2亿美元,同比增长206%;净利实现92.43亿美元,同比增长1259%(12.59倍);GAAP摊薄后每股收益为3.71美元,同比增长12.74倍。

价格层面,目前国内可以买到的H800、A100/A800价格都已超过20万/张。

以2000P算力需求为例,H800 GPU单卡算力2P,需要1000张,预测整个卡价格为2亿元;A800单卡算力约为0.625P,需要数量为3200张,预计整个显卡价格就高达3.2亿元。此外,服务器还要考虑整机配置运算,包括CPU、存储、NVLink互连等,以及电力消耗、场地租金和运维成本等因素,价格进一步攀高。

其次,GPU在4000亿美元规模的 AI 加速芯片市场变得越来越关键。

AMD首席执行官苏姿丰(Lisa Su)公布的一份数据显示,一年前,她认为2023年的AI加速器市场为300亿美元。到2027年,全球数据中心AI加速器的市场规模将达到1500亿美元,这意味着期间的年复合增长率(CAGR)约为50%。但现在苏姿丰认为,2023年AI加速器的市场规模450亿美元,未来几年的CAGR将高达70%,预计推动整个市场到2027年增加到4000亿美元规模。

英伟达企业计算副总裁曼努维尔·达斯(Manuvir Das)给出了另一份数据显示,预计 AI 所在的潜在市场(TAM)规模将增长至6000亿美元。其中,芯片和系统可分得3000亿美元,生成式AI软件可分得1500亿美元,另外1500亿美元则由英伟达企业软件贡献。

很显然,长期来看,芯片对于 AI 算力发展至关重要。

那么2023年,谁抢到了最多英伟达GPU?

研究机构Omdia最新报告显示,微软、Facebook母公司Meta两家公司分别从英伟达购买了15万块H100 GPU芯片,而谷歌、亚马逊和甲骨文等公司各抢到了5万块GPU。同时,中国厂商中,腾讯购买了5万块H800 GPU,百度和阿里巴巴分别购买了3万和2.5万块A100 GPU。

目前,英伟达占据全球数据中心 AI 加速市场82%的份额,并以95%的市场占有率垄断了全球 Al 训练领域的市场,成为这轮 AI 混战中最大赢家。

“没有大算力做大模型就是天方夜谭。”中国工程院院士、鹏城实验室主任高文曾表示,算力已经成为是数字经济发展的一个指标,算力够,你的数字经济就能发展好,不够就发展不好。

最后,在新一轮 AI 算力竞赛中,相比英伟达,国产 AI 算力芯片生态较弱,尤其是在模型训练层面。

钛媒体App曾公布过一组数据,目前在大模型推理方面,国内 AI 芯片910B仅能达到A100的60%-70%左右,集群的模型训练难以为继;同时,910B在算力功耗、发热等方面远高于英伟达A100/H100系列产品,且无法兼容CUDA,很难完全满足长期智算中心的模型训练需求。

王小川曾提到,目前大模型行业算力分训练、推理两部分,合计成本占大模型总成本的40%以上。如果中国要想解决好 AI 算力需求问题,推理部分中国需要有国产算力能力,只有英伟达(垄断)是不够的,而训练部分依然需要英伟达,中国大体顶不上,现在有天花板。“这是整个(行业)都要解决的问题。”

从国内来看,大部分国产GPU芯片都是推理类型的,仅有壁仞科技、天数智芯、寒武纪、昇腾等公司曾公布过 AI 训练芯片。然而,这些厂商的软件生态依然不及英伟达的CUDA,只能兼容CUDA旧的版本。

当然,未来推理芯片依然会成为关键产品。12月7日彭博公布的一段视频中,苏姿丰提到,未来4000亿美元规模中,将有50%以上的市场来自推理需求。

360公司董事长兼CEO周鸿祎提到,最近硅谷有一种趋势,奥特曼(Sam Altman)、微软、Meta、亚马逊、高通等科技厂商都在做推理芯片。他认为未来一到两年,大模型推理过程将不再需要借助昂贵的GPU就可以实现技术迭代,把算力成本降下来。“我个人觉得,这个成本很快不是问题。”

管制方式带来变数,英伟达在中国市场的未来何去何从?魔高一尺,道高一丈。

今年11月初,市场开始流传,英伟达即将推出三款“中国特供版”芯片HGX H20、L20 PCle、L2 PCle,分别针对训练、推理和边缘场景,以及低于美国管制红线的NVIDIA RTX 4090D消费级显卡,以合规形式向中国出口销售。

据钛媒体App了解,即将发售的“中国特供版”HGX H20在带宽、计算速度等方面均有所限制,理论上,整体算力要比英伟达 H100 GPU芯片降80%左右,而且增加HBM显存和NVLink互联模块以提高“无效”的训练算力成本。预计,HGX H20最快将于明年一季度(2月)发布。

“我们成立公司就是为了做生意,努力与所有可能的人做生意。”黄仁勋日前表示,英伟达将继续“完美”遵守贸易法规,并为中国市场提供一套符合美国政府最新规定的新产品。他补充称,英伟达需要寻求市场的建议,这一过程正在进行中。

然而,这种“猫鼠游戏”——只要美国禁令“划出一条线”英伟达就总会“阉割特供”。但现在,美国政府似乎意识到这一点。

12月2日在2023年里根国防论坛(RNDF 2023)开场圆桌对话上,雷蒙多直言,芯片与人工智能(AI)对于美国的国家安全很重要,“我们不能让中国获得这些芯片。”

她认为,芯片厂商应该理解政府出口管制的实质目的,而不仅仅是满足某几个技术参数。美国公司将需要适应美国的国家安全优先事项,包括对BIS半导体出口实施的出口管制。

“我知道在座有芯片公司CEO在对我这样做有点愤怒,因为你正在失去收入,”雷蒙多称,“这就是生活。保护我们的国家安全比短期收入更重要。我们必须与产业界达成一致。”

美国商务部长雷蒙多

雷蒙多的表态被视为美国政府对英伟达策略的公开示警。据了解,美国政府方面正在建立一个超过100人的团队,这个团队主要负责半导体方面的工作,以提高美国商务部和BIS在人工智能等方面的技术能力。

实际上,美国政府已经开始向英伟达传递压力。2023年10月新出口管制规定实施后,存在30天的缓冲期。在缓冲期内,既往订单仍可以交付,市场一度认为英伟达会利用缓冲期抢单向中国客户交付芯片(最多13个月),但在新版出口禁令出台之后6天,美国政府就撤回了30天的许可豁免权限,英伟达发布的公告中称:接到美国政府的通知,对GPU产品的出口禁令即刻生效。

如今,无论是降低规格,还是说无法使用英伟达、AMD AI芯片进行算力训练,美国芯片出口管制已经对 AI 行业产生影响,阿里、腾讯均已经表达担忧情绪。

11月15日,腾讯控股(00700.HK)在财报电话会议上罕见提及芯片限售情况。腾讯总裁刘炽平表示,虽然腾讯目前拥有最多的 AI 芯片库存之一,短期内芯片禁令并不会影响腾讯 AI 能力,但长期看,美国芯片管制确实影响了腾讯将这些 AI 芯片资源作为云服务对外租赁的能力。

11月16日晚,阿里巴巴集团(NYSE:BABA/09988.HK)在2024财年第二季度(即2023自然年第三季度)财报公告中指出,因美国扩大先进计算芯片出口管制,给阿里云智能集团前景带来不确定性,因此阿里不再推进云智能集团的完全分拆。

另外,最近一个月,阿里云、滴滴、腾讯视频、钉钉等产品服务出现了长时间的“断连”情况。有分析认为,这与数据中心芯片减少、服务器运维停顿等因素有关。

阿里董事长蔡崇信曾表示,中国80%的科技企业和超过50%的AI大模型公司跑在阿里云上。而随着阿里云“崩”上热搜,促使更多人思考,英伟达 AI 芯片禁售,未来可能将对中国 AI 公司的业务产生长期影响。

当然,虽然美国政府不想让黄仁勋“赚钱”,但中国人也希望将芯片留在国内。

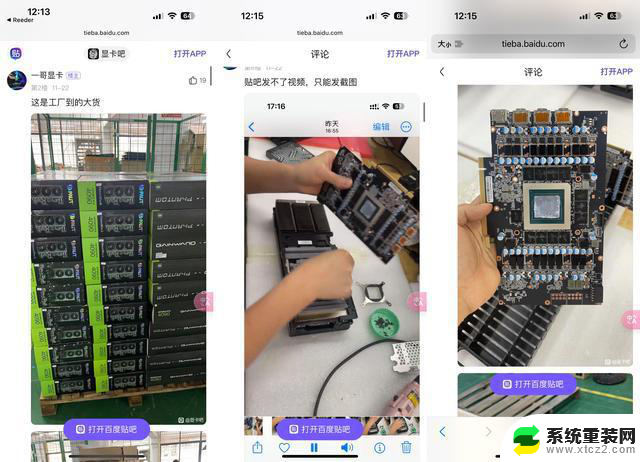

最近在社交媒体上的一则帖子中显示,工人在美国工厂中将英伟达RTX 4090显卡拆卸掉,只保留芯片,并把logo涂掉,通过海运方式留到国内 AI 公司中做模型训练使用。

国产芯片也在努力。有行业人士告诉钛媒体App,“最近卖国产910B芯片的销售人员,经常拿着机箱到大学和研究机构里面,让教授博士们免费使用,说服更多人应用国产 AI 芯片。”

黄仁勋近期在纽约公开表示,“美国出口管制新规带来了很多意想不到的后果。他已经看到中国至少有多达50家公司,正在开发与英伟达竞争的技术”。

12月6日新加坡交流活动中,黄仁勋再次表示,华为、英特尔以及越来越多的半导体初创公司对英伟达在 AI 加速器市场的主导地位构成了严峻的挑战。其中,华为是英伟达“非常强大”的竞争对手之一。

很显然,在巨大的规模和市场机遇下,英伟达对于中国市场巨大的商业价值无法割舍。

今年第三季度财报上,英伟达CFO Colette Kress披露称,英伟达在中国以及其他更新禁令后出口受限制地区的销售额,约占数据中心总销售额的20%~25%。其中,英伟达在中国的相关销售额达20%左右。此外,英伟达还表示,美国新规实施后,预计今年第四季度其产品在中国的销售额将大幅下降。

“因此,我们要在算力里面‘两条腿’走路。”杨迪文表示,一方面大模型企业将仍优先使用英伟达合规芯片,另一方面要购买国产算力,在一些环节中采用国产芯片,或购买国产算力云进行训练,起到一个“主心骨”角色。不过,国产芯片生态依然需要很长的路要走。

一位云计算服务商向钛媒体App坦言,如今的形势已经非常清楚,美国出口管制政策短期内没有松动的可能,发展国产芯片是一种必要的选择。

钛媒体App梳理多份研究机构统计,预计接下来五年内,全球、中国的 AI 芯片市场规模的增长速度将翻10倍以上,有望成为增速最快的科技领域。

12月7日,IDC中国副总裁周震刚表示,在英伟达A800/H800禁止对中国供应之后,大模型算力面临“无卡可用”的问题,与国产芯片的单卡算力差距较大。H20的计算能力为148T,而A800为300多T,H800为700多T。因此,未来美国对中国的AI芯片出口可能需要申请豁免,当然美国和中国商务部仍在进行谈判。

“那么,是不是美国芯片禁令会限制中国的AI发展,中美 AI 会拉开差距?我认为,单卡算力有意义,但不是决定性能力。实际上 AI 模型训练是万卡级别集中在一起,需要整合系统去发挥效能,而非一张卡。”周震刚指出,根据IDC数据显示,2020年,智能算力规模(基于FP16计算)达到75 EFlops,预计到2027年,这一数字增长至1117.4 EFlops,8年增长超15倍。

未来,随着美国芯片管制持续收紧,英伟达“阉割”芯片逐渐将不再是中国客户的唯一选择。届时,中国作为全球增速最高的 AI 芯片市场,英伟达却在这一地区失去50亿-70亿美金收入。

那黄仁勋收入减少的“痛”,雷蒙多能补偿吗?

(本文首发钛媒体App,作者|林志佳)

美国商务部长示警黄仁勋“芯片不准卖中国”,英伟达“中国特供”生意将如何延续相关教程

- 美国商务部长点名威胁英伟达,向国会“讨钱”防中国尖端半导体赶超

- 美国对中国进行芯片管制,英伟达遭殃,市值暴跌4000亿

- 美媒宣布:英伟达停止为中国提供高端显卡,华为受冲击

- 英伟达两大隐忧,一个在中国,另一个也在中国——中国市场和供应链问题

- 华西证券深度报告:谁是国产英伟达?探讨中国GPU巨头

- 夹缝中的英伟达中国 | 深氪lite:深度解析英伟达在中国市场的挑战与机遇

- 英伟达与四家中国电动汽车制造商合作自动驾驶系统,继续扩张在华业务

- 英伟达透露:美政府要求立即停止向中国出口先进人工智能芯片

- 美国芯片管制收紧,英伟达股价下跌,中方砸6469亿反制已启动

- 英伟达下“封杀令”:不准转译CUDA!国产GPU企业回应,如何应对?

- 如何正确更新NVIDIA显卡驱动以提升性能和稳定性?

- 微软最新营销暗示Xbox品牌“不再被游戏机硬件限制”,全新游戏体验尽在掌握

- 微软斯宾塞暗讽PS5 Pro:1000美元的主机无法推动市场增长

- 芯片巨头AMD将全球裁员4%,涉及员工约1000人,原因和影响分析

- 也来凑热闹 微软游戏部门负责人谈Xbox掌机:探讨微软最新游戏主机发展趋势

- 微软发布Win11 27749 Canary预览版:增强讲述人功能优化

微软资讯推荐

- 1 微软最新营销暗示Xbox品牌“不再被游戏机硬件限制”,全新游戏体验尽在掌握

- 2 微软斯宾塞暗讽PS5 Pro:1000美元的主机无法推动市场增长

- 3 AMD确认裁员4%,以便将资源投向“最大的增长机会”:公司精准战略调整!

- 4 如何有效解决CPU温度过高的问题与方法,降低CPU温度的有效技巧

- 5 如何查看和识别显卡型号的详细步骤与方法,快速识别您电脑显卡型号

- 6 高通自研Oryon CPU:性能“至尊”之选

- 7 如何查看显卡型号及其详细信息的方法指南:轻松掌握显卡型号查询技巧

- 8 详细步骤教你如何重装Windows系统,让电脑恢复原装

- 9 详细指南:如何轻松查看显卡温度及其影响 - 完整教程和技巧

- 10 搭载NVIDIA RTX的AI工作站,加速并优化AI开发2021最新

win10系统推荐